Первый слайд презентации: Метод Шенно-Фано

Выполнил студент группы 6011 мочалин роман игоревич

Вероятность приема нуля 0,5*(1-0,04)+0,5*0,02=0,49 Если передан ноль, то вероятность приема нуля 1-0,04=0,96

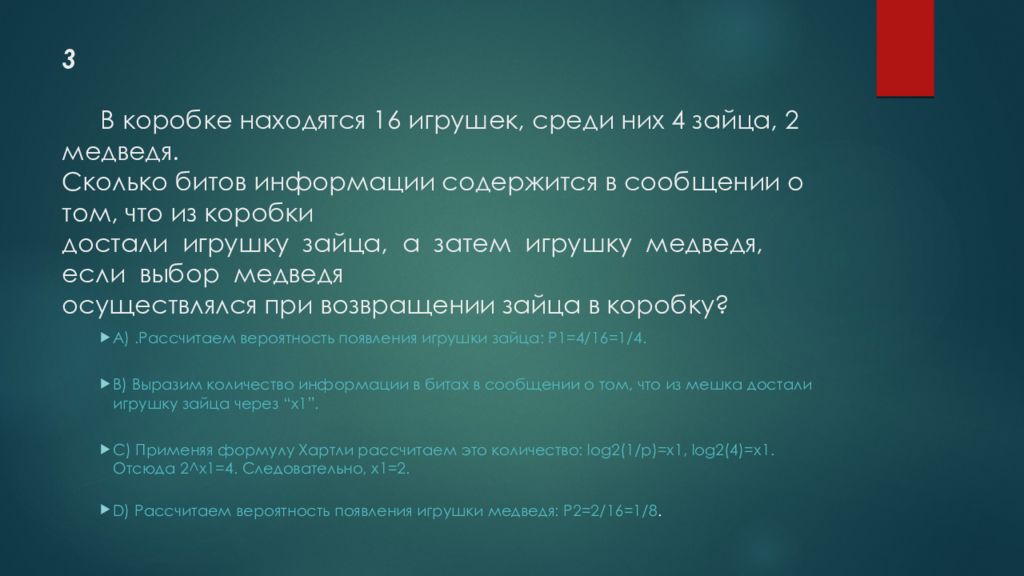

A).Рассчитаем вероятность появления игрушки зайца: Р1=4/16=1/4. B) Выразим количество информации в битах в сообщении о том, что из мешка достали игрушку зайца через “х1”. C) Применяя формулу Хартли рассчитаем это количество: log2(1/p)=x1, log2(4)=x1. Отсюда 2^x1=4. Следовательно, x1=2. D) Рассчитаем вероятность появления игрушки медведя: Р2=2/16=1/8.

Слайд 5

E) Выразим количество информации в битах в сообщении о том, что из мешка достали игрушку медведя через “х2”. F) Применяя формулу Хартли рассчитаем это количество: log2(1/p)=х2, log2(8)=х2. Отсюда 2^х2=8. Следовательно, х2=3. G) В сообщение о том, что из мешка достали игрушку зайца содержится 2 бита информации, а в сообщение о том, что из мешка достали игрушку медведя – 3 бита информации.

Слайд 6: 4 По каналу связи передается сообщение из ансамбля: U = ( ) Средняя длительность передачи одного элемента сообщения в канале τ = 0,2мс. Шум в канале отсутствует. Определить пропускную способность канала и скорость передачи информации

Пропускная способность дискретного канала без шума определяется:

Слайд 7

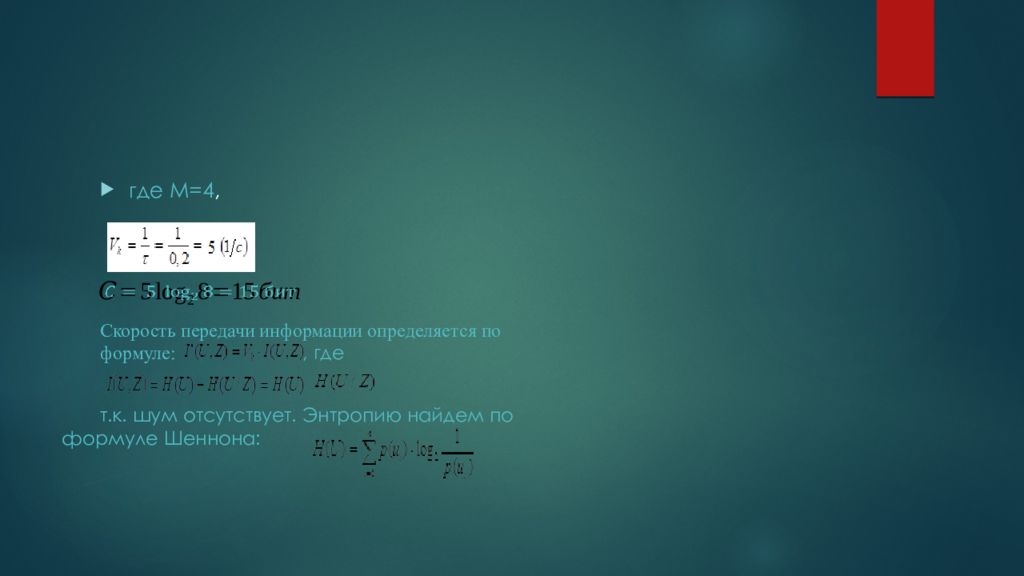

где М=4, Скорость передачи информации определяется по формуле:, где т.к. шум отсутствует. Энтропию найдем по формуле Шеннона :

Слайд 8

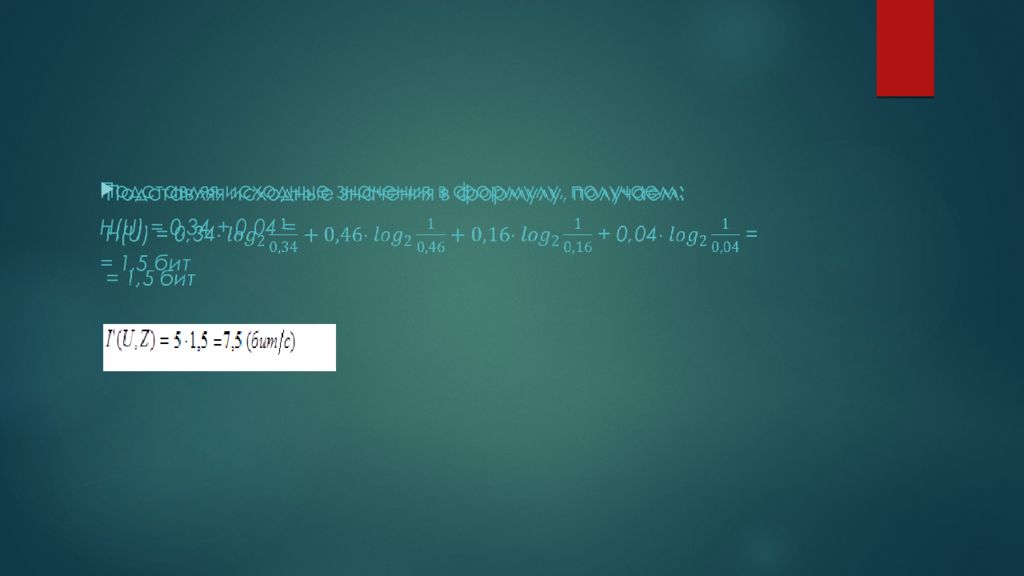

Подставляя исходные значения в формулу, получаем: H(U) = 0,34 + 0,04 = = 1,5 бит

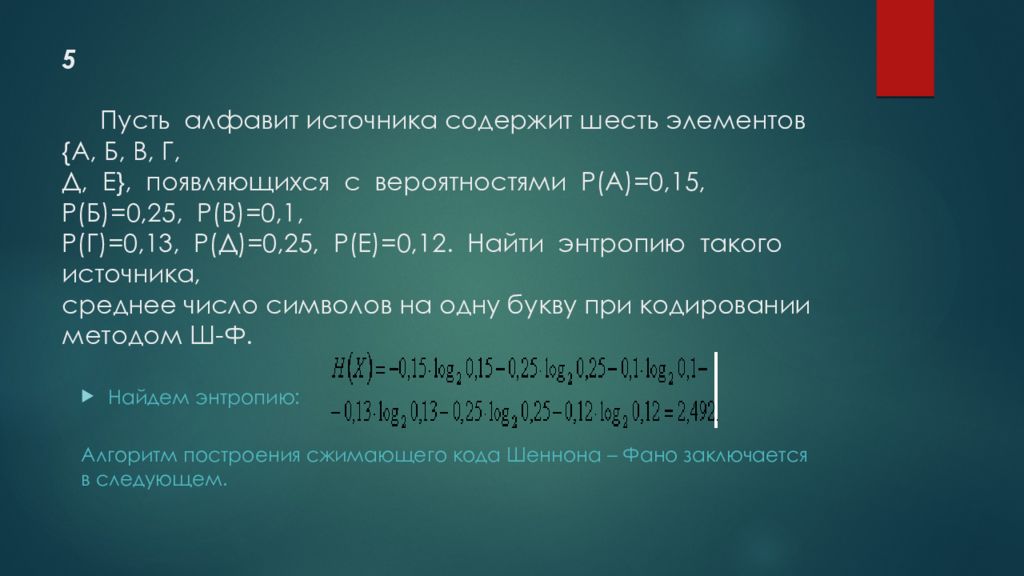

Слайд 9: 5 Пусть алфавит источника содержит шесть элементов {А, Б, В, Г, Д, Е}, появляющихся с вероятностями Р(А)=0,15, Р(Б)=0,25, Р(В)=0,1, Р(Г)=0,13, Р(Д)=0,25, Р(Е)=0,12. Найти энтропию такого источника, среднее число символов на одну букву при кодировании методом Ш-Ф

Найдем энтропию: Алгоритм построения сжимающего кода Шеннона – Фано заключается в следующем.

Слайд 10

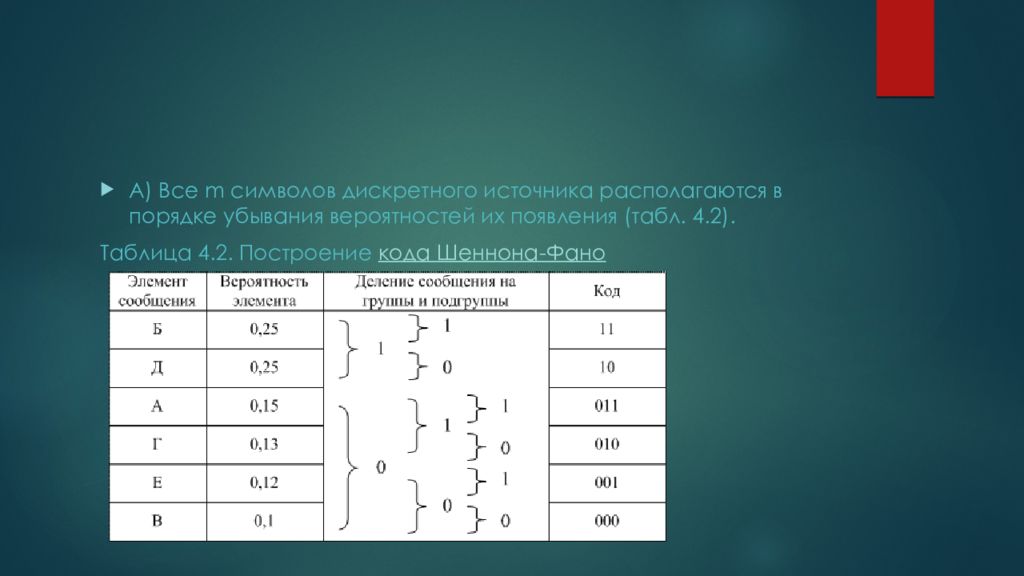

A) Все m символов дискретного источника располагаются в порядке убывания вероятностей их появления (табл. 4.2 ). Таблица 4.2. Построение кода Шеннона- Фано

Слайд 11

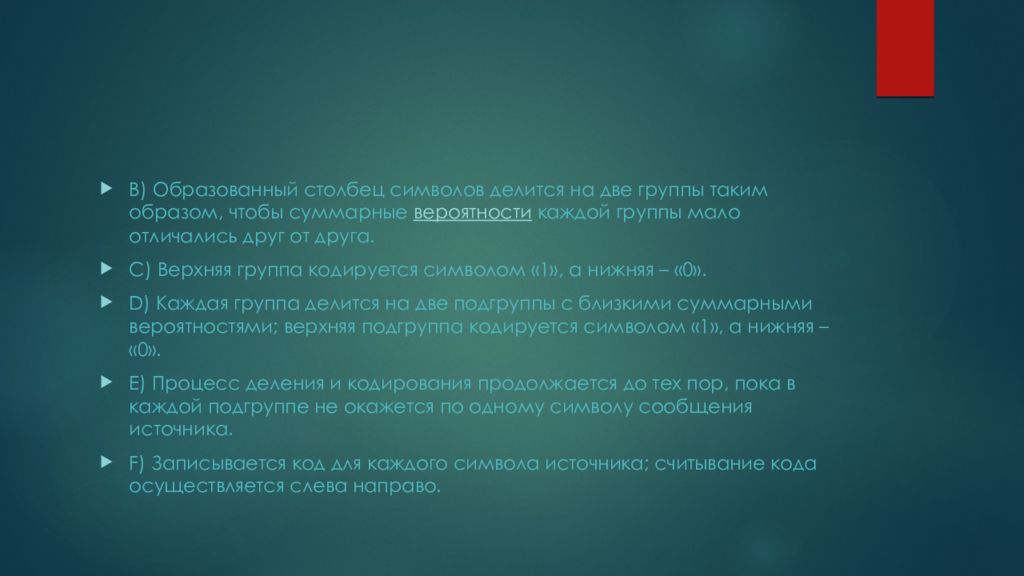

B) Образованный столбец символов делится на две группы таким образом, чтобы суммарные вероятности каждой группы мало отличались друг от друга. C) Верхняя группа кодируется символом «1», а нижняя – «0 ». D) Каждая группа делится на две подгруппы с близкими суммарными вероятностями; верхняя подгруппа кодируется символом «1», а нижняя – «0 ». E) Процесс деления и кодирования продолжается до тех пор, пока в каждой подгруппе не окажется по одному символу сообщения источника. F) Записывается код для каждого символа источника; считывание кода осуществляется слева направо.

Слайд 12

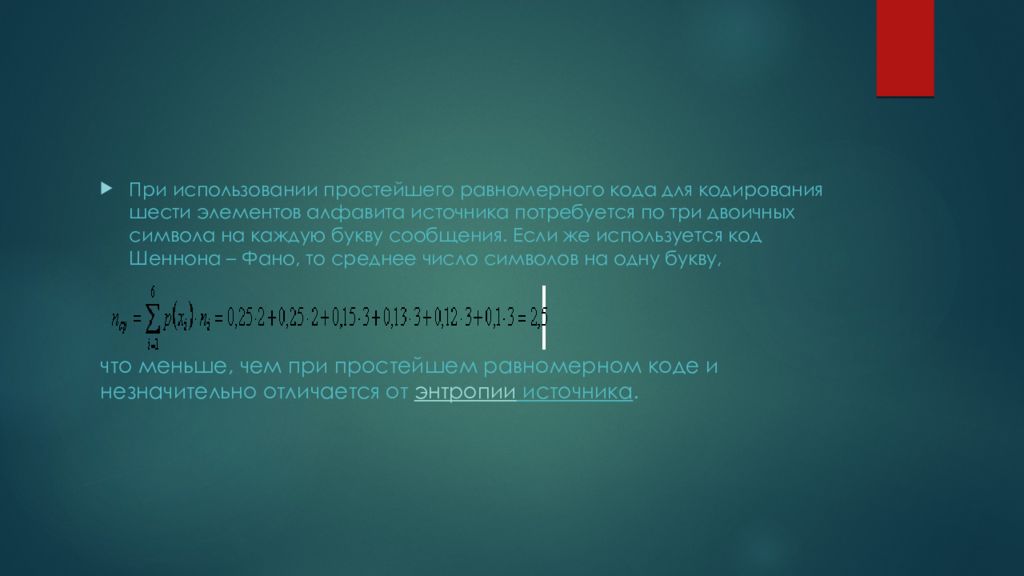

При использовании простейшего равномерного кода для кодирования шести элементов алфавита источника потребуется по три двоичных символа на каждую букву сообщения. Если же используется код Шеннона – Фано, то среднее число символов на одну букву, что меньше, чем при простейшем равномерном коде и незначительно отличается от энтропии источника.

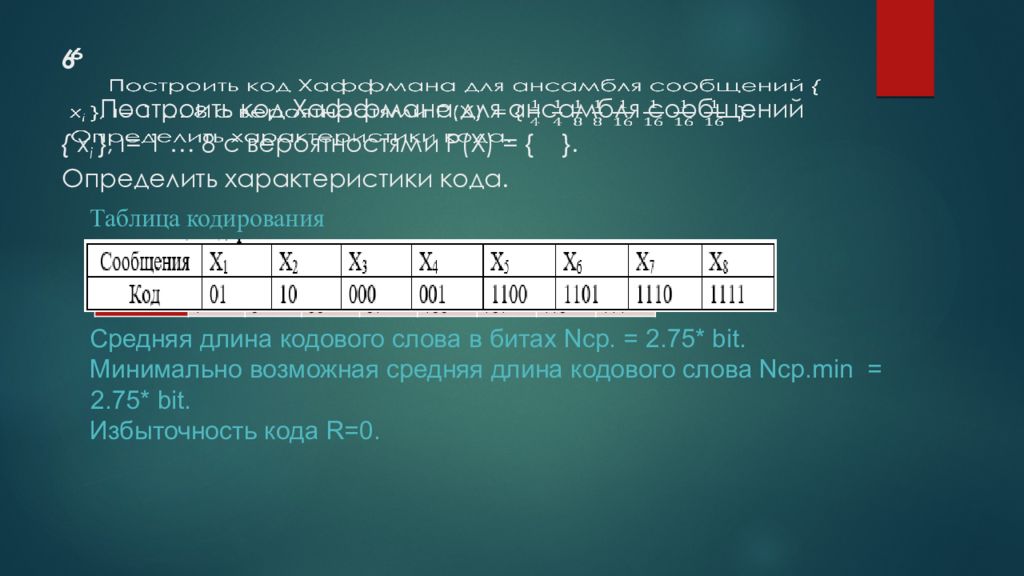

Слайд 13: 6 Построить код Хаффмана для ансамбля сообщений { x i }, ι= 1 … 8 c вероятностями P ( X ) = { }. Определить характеристики кода

Сообщения Х 1 Х 2 Х 3 Х 4 Х 5 Х 6 Х 7 Х 8 Код 01 10 000 001 1100 1101 1110 1111 Таблица кодирования Средняя длина кодового слова в битах N cp. = 2.75* bit. Минимально возможная средняя длина кодового слова N cp.min = 2.75 * bit. Избыточность кода R=0.

Последний слайд презентации: Метод Шенно-Фано: 7 Сколько информационных символов содержится в коде, исправляющем одиночную ошибку при числе информационных комбинации N=32

Для вычисления основных параметров кода Хэмминга задается количество информационных комбинаций Из этого следует, что n и = 5